Geçtiğimiz günlerde iPhone ve diğer Apple cihazları üzerinden kullanıma sunulacağı duyurulan yapay zeka özelliklerinin nasıl eğitildiğine dair detayların yer aldığı araştırma raporunda, Cupertino merkezli teknoloji devinin piyasa lideri NVIDIA yerine Google’ın yapay zeka yongalarını tercih ettiği ortaya çıktı. Bugüne kadar GPU’larına gösterilen yoğun talep, NVIDIA’nın gelirini ve kârını hızla katlayarak piyasanın zirvesine yerleşmesini sağlamıştı.

Ancak raporda Apple’ın 2,73 milyar parametreli Apple Foundation Model (AFM) adlı modelinin genellikle Google tarafından sağlanan v4 ve v5p tensor işleme birimi (TPU) bulut kümelerini kullandığı belirtildi.

Apple, Yapay Zeka Süreçlerinde GPU Yerine TPU Kullanıyor

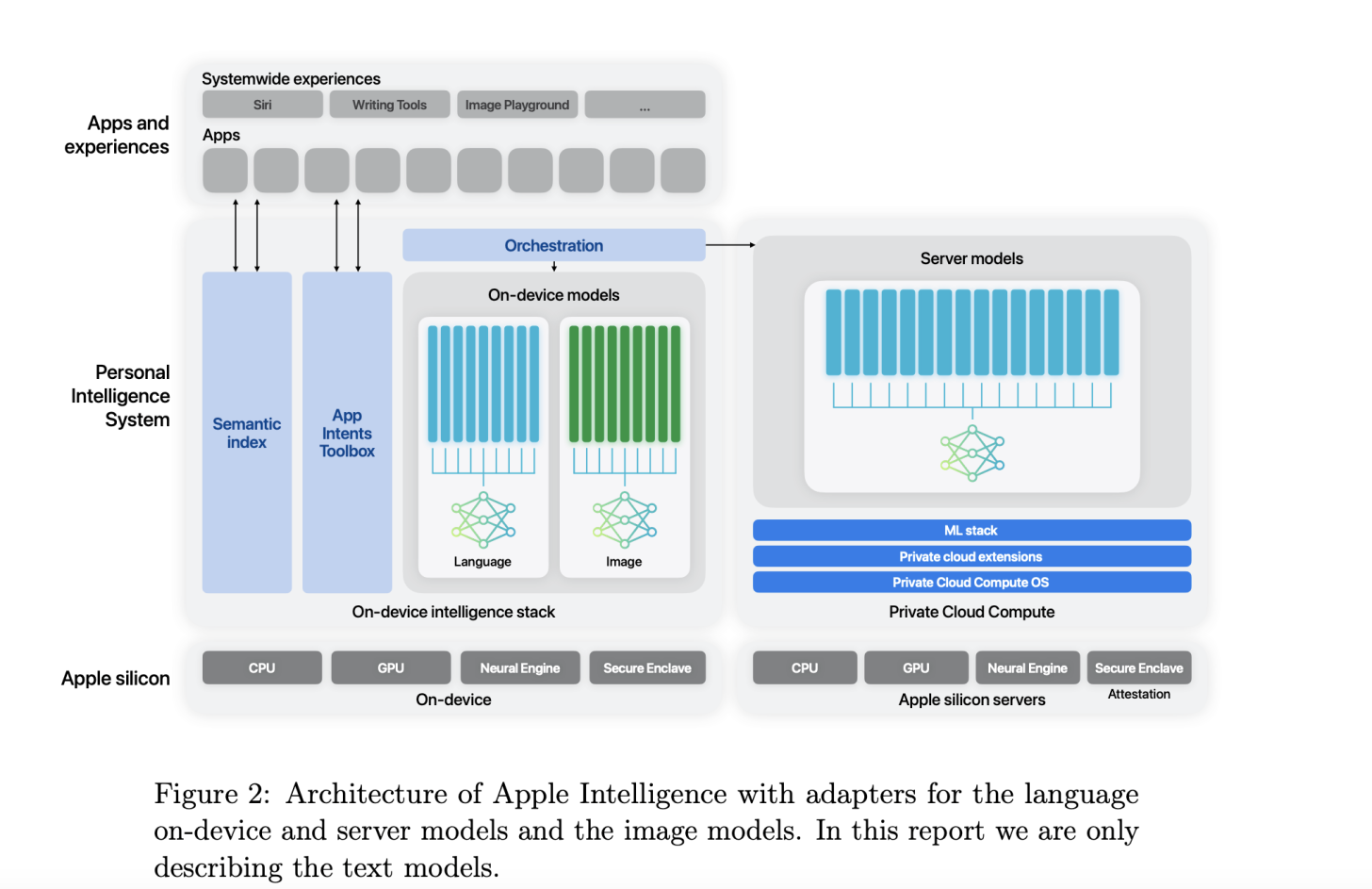

Geçtiğimiz günlerde yayınlanan raporda Apple’ın bu yılın başlarında WWDC’de duyurduğu yapay zeka özelliklerini mümkün kılacak yapay zeka modellerinin eğitim altyapısı ve diğer detaylar yer alıyor. Apple, hem cihazda hem de bulutta çalışan yapay zeka işleme özelliklerini duyurmuştu ve bu özelliklerin kalbinde Apple Foundation Model (AFM) adı verilen yapay zeka modeli bulunuyor.

AFM’nin sunucu tarafı, yani buluttaki yapay zeka özelliklerini sağlayacak model olan Apple Cloud Compute, 8192 TPUv4 yongalar üzerinde sıfırdan eğitiliyor. Google’ın TPUv4 yongaları, her biri 4096 yongadan oluşan podların üzerinde bulunuyor.

Apple, AFM modellerinin (hem cihaz hem de bulut üzerindeki) TPUv4 yongaları ve v5p Cloud TPU kümeleri üzerinde eğitildiğini belirtti. v5p, Google’ın geçtiğimiz Aralık ayında duyurulan Cloud AI süper bilgisayarının bir parçası.

Her bir v5p podunda 8.960 yonga bulunuyor ve Google’a göre TPU v4’e göre iki kat daha fazla kayan nokta işlemi (FLOPS) ve üç kat daha fazla bellek sunarak modellerin yaklaşık üç kat daha hızlı eğitilmesini sağlıyor.

Apple, yazma ve görüntü seçimi gibi özellikler sunan cihaz üzerinde çalışan yapay zeka modeli için AFM sunucusu ile aynı süreç kullanılarak sıfırdan eğitilmiş olan 6,4 milyar parametreli bir model kullanıyor. Apple, AFM sunucu modeli için eski nesil v4 TPU yongalarından faydalanıyor. Yukarıda belirtildiği gibi burada 8092 v4 TPU yongasını tercih eden şirket, cihaz üzerinde çalışan AFM modeli için daha yeni yongaları tercih ediyor. Apple bu modelin 2048 TPU v5p yongasıyla eğitildiğini belirtiyor.

Makalede ayrıca modelin zararlı yanıtları değerlendirme, hassas konular, bilgi doğruluğu, matematik performansı ve insanların model çıktıları konusundaki memnuniyeti gibi alanlarda değerlendirildiği belirtiliyor. Apple’a göre AFM sunucusu ve cihaz üzerindeki modeller, zararlı çıktıların önlenmesi konusunda sektörde lider durumda.

Örneğin Apple verileri, OpenAI GPT-4’ün zararlı çıktı ihlal oranı %28,8 iken AFM sunucusunun %6,3 gibi çok daha düşük bir değer sunduğunu gösteriyor. Benzer şekilde cihaz üzerinde çalışan AFM, %7,5 ihlal oranıyla Facebook’un ana şirketi Meta tarafından eğitilen Llama-3-8B’nin %21,8’lik skorundan çok daha düşük bir değer veriyor.

Cihaz üzerinde çalışan AFM modeli e-posta, mesaj ve bildirim özetlemesi için sırasıyla %71,3, %63 ve %74,9 memnuniyet oranına sahip. Makalede bu oranların Llama, Gemma ve Phi-3 modellerini geride bıraktığı belirtiliyor.

Kaynak: wccftech.com